Ausgehend von Anmerkungen zum Begriff Regression und seiner Geschichte werden Anwendungsfelder und zentrale Arbeitsschritte der Regressionsanalyse umrissen. Die Schätzmethode der kleinsten Quadrate und alternative Schätzmethoden werden diskutiert und Modellerweiterungen vorgestellt.

Historische Anmerkungen

Der Begriff „Regression“ wurde von Francis Galton 1886 als statistischer Fachbegriff geprägt und beschrieb seiner Zeit die von ihm und dann von Karl Pearson und Alice Lee 1903 festgestellte Beobachtung, dass überdurchschnittlich große (kleine) Eltern tendenziell überdurchschnittlich große (kleine) Kinder haben und dass die Abweichungen vom Mittelwert im Laufe der Generationen gegen Null und damit die Körpergrößen selbst zum Mittelwert hin tendieren („Regression zum Mittel“). In der heutigen statistischen Sprache würde man davon sprechen, dass am Anfang der statistischen Regressionsanalyse die Untersuchung des Einflusses der unterschiedlichen Körpergrößen der Eltern auf die unterschiedlichen Körpergrößen der Kinder stand.

Definition

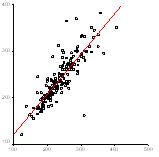

Ganz allgemein versteht man heute unter Regression eine spezielle multivariate Analysetechnik zur Untersuchung der Art und der Stärke der Abhängigkeit einer (seltener: mehrerer) abhängiger quantitativen Variablen von mehreren (seltener: einer) quantitativen unabhängigen Variablen um bei gegebenen Beobachtungswerten der unabhängigen Variablen den zu erwarteten Wert der abhängigen Variablen möglichst gut prognostizieren zu können und die Variabilität der abhängigen Variablen durch die systematischen Einflüsse der unabhängigen Variablen erklären und von zufälligen Einflüssen unterscheiden zu können. Die Regressionsanalyse ist die wichtigste quantitative empirische Methode.

Anwendungsfelder

In der deskriptiven Statistik werden Regressionsanalysen zur Beschreibung von Abhängigkeiten in einem gegebenen Datensatz metrisch skalierter Merkmale benutzt. In der modernen empirischen Wirtschafts- und Sozialforschung ist es Ziel mittels adäquat spezifizierter Regressionsmodelle auf der Grundlagen von Daten, die als Stichprobenrealisationen interpretiert werden, generelle Aussagen zur Erklärung (sozio)ökonomischer Gesetzmäßigkeiten und zur Überprüfung von Hypothesen über Abhängigkeiten zu treffen. Da im sozioökonomischen Bereich deterministische Gesetzmäßigkeiten eher selten zu erwarten sind, bedient sich die Regressionsanalyse stochastischer Modelle. Die Spezifikation des Regressionsmodells erfordert also die Festlegung der abhängigen und der unabhängigen relevanten Variablen im Modell, die Vorgabe einer möglichst einfachen funktionalen Form der Abhängigkeit und der zu schätzenden Parameter der Regressionsfunktion, die Festlegung der wahrscheinlichkeitstheoretischen Eigenschaften eines stochastischen Terms (um systematische von zufälligen Einflüssen trennen zu können).

Modellorientiertes versus datenorientiertes Vorgehen

Aus klassischer Sicht der Statistik wird ein modellorientiertes Vorgehen, das sich auf die aktuelle theoretische Literatur stützt, bei der Modellspezifikation gegenüber einem rein datenorientierten Vorgehen vorgezogen. In der Praxis finden sich häufig Mischformen. Die Parameter des Modells sind auf Grund eines Datensatzes mittels geeigneter Schätzmethoden zu schätzen, Hypothesen werden mittels Hypothesentests an Hand der geschätzten Regressionsfunktion überprüft.

Schätzmethoden

Die in der Praxis am häufigsten eingesetzte Schätzmethode zur Schätzung numerischer Werte für die Modellparameter ist die Methode der Kleinsten Quadrate (OLS = Ordinary Least Squares). Unter der Annahme korrekter Modellspezifikation und unter sehr allgemeinen und häufig plausiblen Zusatzannahmen (wie die Normalverteilungsannahme) liefert diese Methode erwartungstreue, effiziente, konsistente, und suffiziente Schätzer. Verletzungen der Annahmen durch Nichtaufnahme von relevanten Variablen als erklärende Variable, durch Aufnahme von irrelevanten erklärenden Variablen, durch Aufnahme von (stochastisch) abhängigen Variablen als erklärende Variablen, durch falsche Wahl der funktionalen Form sowie durch Fehlspezifikation der stochastischen Modelleigenschaften (keine Autokorrelation des stochastischen Terms, Homoskedastizität) führen zu entsprechenden Variablentransformationen vor Anwendung von OLS oder zur Verwendung alternativer Punktschätzer (GLS = Generalized Least Squares, GMM = Generalized Method of Moments, IV = Instrumental Variables, ML = Maximum Likelihood). Häufig werden dann auch nur die Varianzschätzer entsprechend korrigiert. Tools zur Überprüfung der Annahmen (graphische Diagnosetools, Spezifikationstests) sowie alternative Schätzverfahren bieten die einschlägigen statistischen Programmpakete.

Modellerweiterungen

Ausgehend vom einfachen linearen Grundmodell (linear in den Parametern und linear in den Variablen) für metrisch skalierte abhängige und unabhängige Variablen sind eine Reihe von Modellerweiterungen inzwischen Standard in der empirischen Wirtschaftsforschung und in entsprechenden Softwaretools implementiert. So gehören zur modernen Methodenausbildung heute neben dem klassischen Regressionsmodell für Querschnitt- und Längsschnittdaten auch Modelle und Schätzverfahren für spezielle Datenstrukturen wie Paneldaten, für qualitative (un‑) abhängige Variablen, für Zähldaten, für Ereignisdaten, für Mikrodatensätze oder aggregierte Daten sowie zur stochastischen Modellierung von Zeitreihendaten. Neben der traditionellen Analyse von Korrelationen rücken in heutiger Zeit zunehmend Fragen nach Kausalitäten mittels Regressionsmodellen in den Blickpunkt.

Literatur

Auer, Ludwig von:r Ökonometrie. Eine Einführung. 6. Auflage. Springer Gabler 2013.

Baltagi, Badi H.:r Econometrics. 5th Edition. Springer 2011.

Bauer, Thomas K.;r Fertig, Michael; Schmidt, Christoph M.: Empirische Wirtschaftsforschung. Einer Einführung. Springer 2009.

Fahrmeir, Ludwig ;r Kneib, Thomas ; Lang, Stefan: Regression. Modelle, Methoden und Anwendungen. 2.r Auflage. Springer 2009.

Galton, Francis: Family Likeness in Stature.r Proceedings of the Royal Society of London 1886, Vol. 40, pp. 42-73.

Gujarati, Damodar N.: Essentials of Econometrics. 4thr Edition. McGraw-Hill 2009.

Kennedy, Peter: A Guide to Econometrics. 6th Edition.r Wiley-Blackwell 2008.

rKoop, Gary: Introduction to Econometrics. Wiley 2007.

Pearson, Karl; Lee, Alice: On the Laws of Inheritancer in Man. Biometrika 1903, Vol. 2, Num. 4, pp. 357-462.

Stock, James; Watson, Mark W.: Introduction tor Econometrics. 3rd Edition. Pearson 2014.

Studenmund, A. H.: Using Econometrics. A Practicalr Guide. 6th Edition. Pearson 2013.

Wooldridge, Jeffrey M.: Introductory Econometrics.r A Modern Approach. 5th Edition. Cengager Learning 2013